在互联网项目开发中,缓存的应用是非常普遍了,缓存可以帮助页面提高加载速度,减少服务器或数据源的负载。

1、为什么需要缓存?

一般在项目中,最消耗性能的地方就是后端服务的数据库了。而数据库的读写频率常常都是不均匀分布的,大多情况是读多写少,并且读操作(select)还会有一些复杂的判断条件,比如 like、group、join 等等,这些语法是非常消耗性能的,所有会出现很多的慢查询,因此数据库很容易在读操作的环节遇到瓶颈。

那么通过在数据库前面,前置一个缓存服务,就可以有效的吸收不均匀的请求,抵挡流量波峰。

另外,如果应用与数据源不在同一个服务器的情况下,中间还会有很多的网络消耗,也会对应用的响应速度有很大影响,如果当前应用对数据实时性的要求不那么强的话,在应用侧加上缓存就能很快速的提升效率。

2、那使用缓存会遇到哪些问题呢?

虽然缓存可以提高整体性能,但是它也可能会带来别的问题。例如使用缓存之后,就相当于把数据存放了2份,一份是在数据库中,另一份存放在缓存中。当有新的数据要写入或者旧数据需要更新的时候,如果我们只更新了其中一份数据源,那两边的数据就不一致了,所以这里就存在一个缓存数据与数据库数据如何进行有效且快速的同步问题,才可以保证数据的最终一致性。

另外,加上缓存服务其实也引入了系统架构的复杂度,因为还需要额外的关注缓存自身带来的下列问题:

缓存的过期时间问题:设计缓存的过期时间需要非常的有技巧,且必须与业务实际情况相结合。因为如果设计的过期时间太短了,那会导致缓存效果不佳,且还会造成频繁的从数据库中往缓存里写数据。如果缓存设计的过期时间太长了,又会导致内存的浪费。

缓存的命中率问题:这也是设计缓存中需要存放哪些数据的很重要一点,如果设计的不好,可能会导致缓存命中率过低,失去缓存效果。一般对于热点数据而言,要保证命中率达到70%以上效果最佳。

缓存的穿透/雪崩问题:是指如果缓存服务一旦宕机或全部丢失,那么有可能一瞬间所有的流量都直接打到了后端数据库上,可能会造成连锁反应,瞬间的请求高峰极有可能导致数据库无法承载。

3、缓存的更新策略具体有哪些?

典型的缓存模式,一般有如下几种:

Cache Aside

Read/Write Through

Write Behind

每种模式都有不同的特点,适应与不同的项目场景,下面来依次看看:

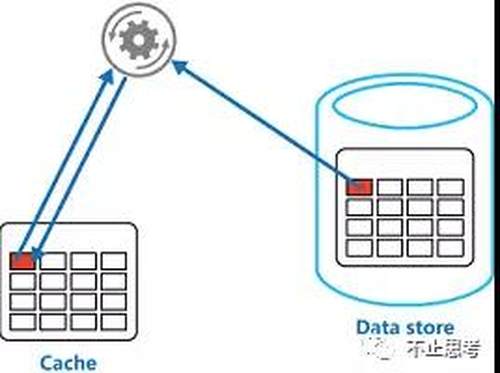

Cache Aside 模式

这是大家经常用到的一种策略模式。这种模式主要流程如下:

应用在查询数据的时候,先从缓存Cache中读取数据,如果缓存中没有,则再从数据库中读取数据,得到数据库的数据之后,将这个数据也放到缓存Cache中。

如果应用要更新某个数据,也是先去更新数据库中的数据,更新完成之后,则通过指令让缓存Cache中的数据失效。

这里为什么不让更新操作在写完数据库之后,紧接着去把缓存Cache中的数据也修改了呢?

主要是因为这样做的话,就有2个写操作的事件了,担心在并发的情况下会导致脏数据,举个例子:假如同时有2个请求,请求A和请求B,并发的执行。请求A是要去读数据,请求B是要去更新数据。初始状态缓存中是没有数据的,当请求A读到数据之后,准备往回写的时候,此刻,请求B正好要更新数据,更新完了数据库之后,又去把缓存更新了,那请求A再往缓存中写的就是旧数据了,属于脏数据。

那么 Cache Aside 模式就没有脏数据问题了吗?不是的,在极端情况下也可能会产生脏数据,比如:

假如同时有2个请求,请求A和请求B,并发的执行。请求A是要去读数据,请求B是要去写数据。假如初始状态缓存中没有这个数据,那请求A发现缓存中没有数据,就会去数据库中读数据,读到了数据准备写回缓存中,就在这个时候,请求B是要去写数据的,请求B在写完数据库的数据之后,又去设置了缓存失效。这个时候,请求A由于在数据库中读到了之前的旧数据,开始往缓存中写数据了,此时写进入的就也是旧数据。那么最终就会导致,缓存中的数据与数据库的数据不一致,造成了脏数据。

不过这种概率比上面一种概率要小很多。所以整体而言 Cache Aside 模式 还是一种比较简单实用的方式。

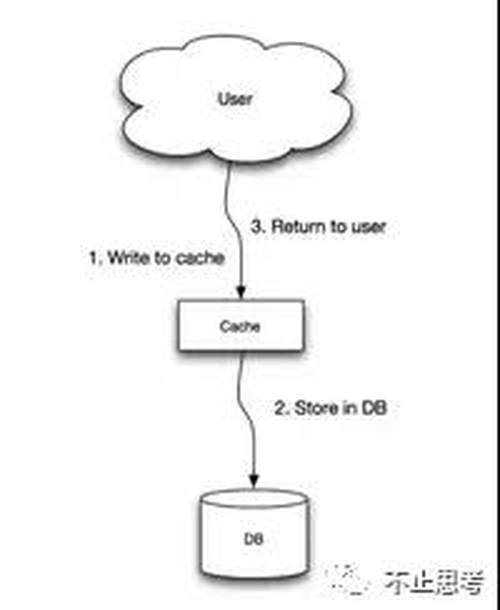

Read/Write Through 模式

这个模式其实就是将 缓存服务 作为主要的存储,应用的所有读写请求都是直接与缓存服务打交道,而不管最后端的数据库了,数据库的数据由缓存服务来维护和更新。不过缓存中数据变更的时候是同步去更新数据库的,在应用的眼中只有缓存服务。

流程就相当简单了:

应用要读数据和更新数据都直接访问缓存服务

缓存服务同步的将数据更新到数据库

这个模式出现脏数据的概率就比较低,但是就强依赖缓存了,对缓存服务的稳定性有较大要求,另外,增加新缓存节点时还会有初始状态空数据问题。

Write Behind 模式

这个模式就是 Read/Write Through 模式 的一个变种。区别就是 Read/Write Through 模式的缓存写数据库的时候是同步的,而 Write Behind 模式 的缓存操作数据库是异步的。

流程如下:

应用要读数据和更新数据都直接访问缓存服务

缓存服务异步的将数据更新到数据库(通过异步任务)

这个模式的特点就是速度很快,效率会非常高,但是数据的一致性比较差,还可能会有数据的丢失情况,实现逻辑也较为复杂。

以上就是目前三种主流的缓存更新策略,另外还有Refrsh-Ahead模式等由于使用的不是很常见就不详细介绍了。

缓存是互联网项目中非常普遍的一个提高效率的方案,用法比较多,也比较关键,大家可以一起交流。

相关推荐

近日,艾肯家电网签约国内知名的CDN网站加速服务提供商北京快网,北京快网将为艾肯家电网提供提全站CDN加速服务。记者了解到,目前国内比较大的门户网站为现实网站的高速访问,早已使用了CDN网络加速。目前,包括腾讯、新浪、搜狐、网易、酷六、红袖添香等众多网站都采用了北京快网的CDN网络加速服务这一服务。据《中国互联网年度综合报告2009-2011》数据显示,预计至2011年互联网市场规模将达到1300亿,互联网总用户数将达到6亿。网民数量的持续提升同时也让互联网服务发展如火如荼,视频、SNS、垂直网站等新兴网站层出不穷,在带来全新商机的同时,也让互联网带宽、服务器等资源捉襟见肘。而CDN服务提供商

9月29日消息,据国外媒体报道,雅虎董事会成员、国际上最大的CDN服务商Akamai总裁大卫·肯尼(DavidKenny)公开表示有意竞选雅虎CEO。国际上最大的CDN服务商Akamai总裁大卫·肯尼知情人士透露,肯尼目前还在管理Akamai的业务,但确定要公开竞选雅虎CEO。该人认为,肯尼对雅虎内部发生的一切非常清楚,知道自己在干什么。昨天,肯尼曾与雅虎产品团队工作人员进行数小时长谈。近日,他还曾与包括私募公司在内的雅虎投资方、股东交换了意见。某科技媒体认为,肯尼适宜担

提起优酷,喜欢看网上视频的人大概没有不知道的。创办于2006年的优酷,因着“快者为王”的产品理念,以“快速播放,快速发布,快速搜索”的特性,满足了互联网用户日益增长的多元化互动需求,从而成为国内视频网站中的领军企业。支持优酷实现快速、优质用户体验的,是优酷背后强大的数据中心和IT技术能力。据优酷CTO姚键介绍,优酷每年的数据增长率大概都在50%。为了应对不断增长的巨大流量带来挑战,2010年,优酷对位于北京的主数据中心进行了改造。简化的二层网络姚键表示,由于优酷提供的视频业务对网络设备提出了时延小、可大规模扩展的要求,因此对网络交换设备的选型十分重要。考虑到主数据中心的战略地位,网络规划设计需

本文介绍介绍了10大前沿运营商级网络技术:GPON,云计算,云手机,CDN,集装箱数据中心,高压直流供电,蒸发式冷却,风光互补基站,RFID。一、GPONGPON技术发源于1995年形成的ATMPON(既APON),最早由FSAN标准组织提出,经ITU-T指定,2004年形成最终标准。一直与EPON处于竞争地位。在亚太地区一直被压制,2010年开始发力,目前新增份额已经开始超越EPON。中移动专宠GPON,中电信、中联通也开始青睐GPON。GPON为运营商提供了更大的分光比、2倍于EPON的下行带宽,在FTTH中优势尤为明显。中国移动研究院网络研究所所长助理李晗——“GPON的DFB+APD提