2023亚太内容分发大会暨CDN峰会于6月29日在北京隆重开幕,亚太CDN产业联盟携手中国移动、火山引擎、腾讯云、网宿科技、阿里云、华为云、中兴通讯、白山云、天翼云等CDN领域头部企业,专家、学者和业界领导,共同探讨打造更高质量的CDN服务推动行业发展,共同把握下一个十年人工智能(AI)新技术带来驱动对算力的需求及网络流量增长的巨大经济价值。阿里云CDN产品负责人容蓓带来了题为“DCDN助力云原生时代的应用构建及最佳实践”的精彩分享。

阿里云CDN产品负责人容蓓

阿里云CDN产品负责人容蓓

阿里云CDN产品负责人容蓓在演讲中提出,互联网时代大家的联系越来越紧密,信息在毫秒之间从地球的一端到达另一端,信息的传递从过去的核心能力,变成了现在的基础能力,信息传递的优化已经全面进入了一个深水区。不同的网络运营商、网络设备、网络协议等,让当今的网络环境变得越来越复杂,所以从协议的优化到算法的优化,路由相关的优化,目的正是为了让网络传输更加有效率。

以前大家都觉得边缘计算是未来的趋势,但是现在已经变成了一个现实,国家也出台了相关的政策推动边缘计算的发展和落地。云原生时代的到来为边缘计算打开了加速的按钮,随着用户访问从边缘逐步下沉,计算也逐步下沉,边缘的数据安全就成为了其中的一环。边缘未来一定不仅仅只有流量的存在,算力的比重会变得越来越大。云和边也不再是两个独立的入口,他们将变成互联依赖,互信储备的关系。

阿里云全站加速在去年持续投资扩大边缘基础的设施规模,在2022年的基础上全站加速的基础设施规模也提升了12.5%,现在中国境内拥有2300个节点,在境外拥有900个节点。中国境内是全域覆盖,在海外是核心地覆盖到东南亚、欧洲等重点的一些区域。随着客群变得越来越大,业务的多样性也变得更明显。

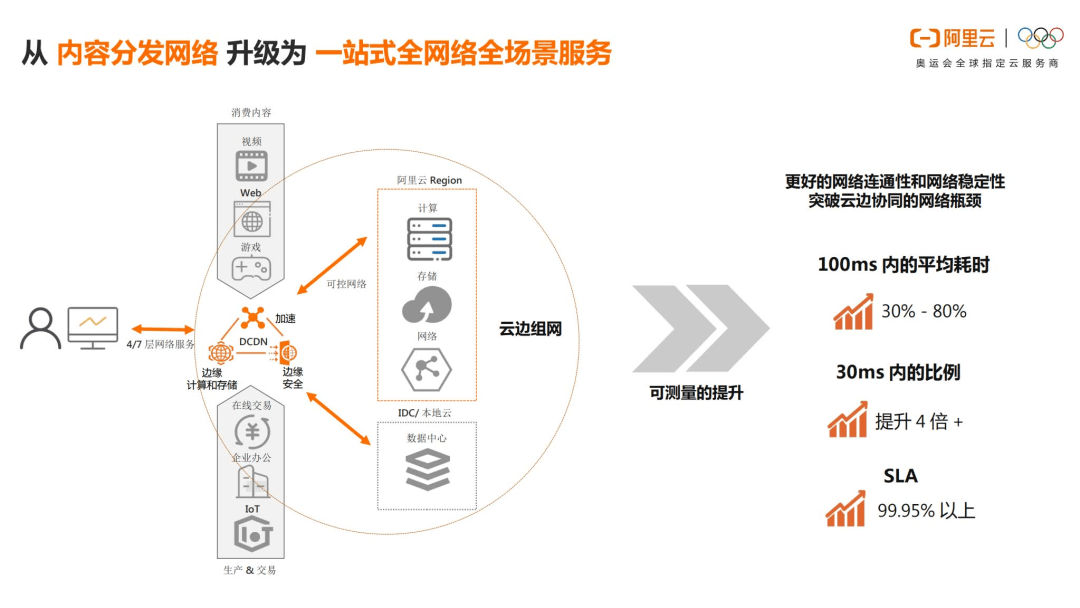

全站加速已经不仅仅只是提供动静态加速的产品,它现在同时也能够去提供边缘计算和边缘安全的能力,满足不同的客户诉求。在过去一年中,全站加速在运力、算力和防力上都进行了持续升级。首先,运力是全站加速网络传输能力,也是最底座的一个能力,可以帮助API服务或者是动静态内容在边缘上车点实现客户就近上车。客户在就近上车的时候,边缘节点可以大幅卸载传输层,减少网络交互的往返次数。同时也优选了一批节点,从节点建设、运维、管控进行独立管理。

另外在节点间升级了路由的决策系统策略,在内部链路里可以实现0RTT机制,走最快路径,回到数据中心。全站加速整个网络架构进行了整体升级,云边进行组网,使云边之间的网络架构成为一个可控的网络架构,解决了云边以前只能通过公网来访问带来一些不可靠问题的情况。

容蓓介绍了客户提供的一组端上访问数据。客户从中心数据接入,切换到边缘全段加速之后,TCP百秒平均耗时以及30毫秒内的占比,都得到了大幅度提升。客户数据中心是在江浙地区,中心和边缘差距还没有很大,一旦离开了江浙地区,数据的差异就非常明显。

阿里云团队在主导推进传输协议的标准制定的同时,也在工业界与团队做实践。Multipath QUIC是指在4G、5G或者是WIFI不同网络环境下,同时去传输数据会优选网络环境更快的数据包。Multipath QUIC支持上下行的双路传输,根据不同的场景来选择不同的调度算法和机制,满足不同的性能要求。在XR应用场景下,3D模型下载需要非常大的带宽下载,或者3D直播对延迟敏感性非常高,同时对大带宽有一些诉求,所以可以通过多路并行传输,来优化实现效果。

通过Multipath QUIC传输,比通过单路视频传输在起播速度和播放顺滑度更优,再给端上用户使用时,带来一个肉眼可见的性能提升。

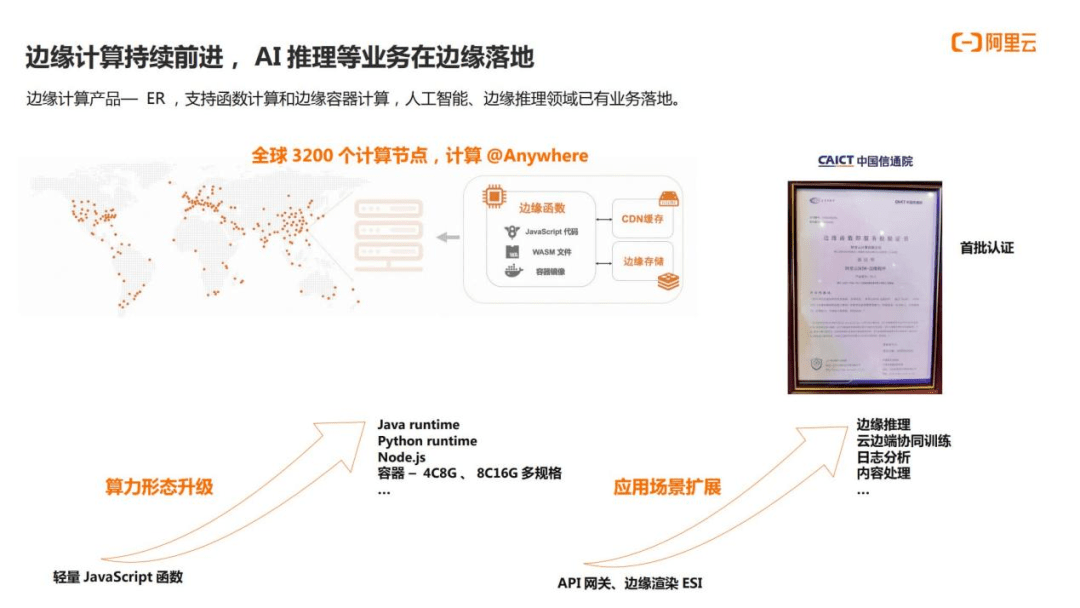

容蓓对全站加速的计算能力进行了讲解。边缘计算产品是ER,目前接入了上百家客户,在手淘、优酷一些头部客户应用里较为广泛。2022年双11,ER顺利通过了千万级QPS高并发的时段考验。在2023年,ER产品获得了中国信通院认可,首批通过了边缘函数级服务的认证。如果轻量函数已经无法实现部分计算规则,ER可以支持在边缘通过API上传镜像,把镜像上传到边缘结点,通过边缘容器来完成边缘计算。全站加速可以对整个边缘算力进行调度,支持4核8G、8核16G等的边缘容器服务。ER构建了一套边缘算力的调度系统,可以将端上的算力请求调度到就近节点完成计算,ER会实时感知算力需求以及端上热度,进行及时扩容或者是缩容,期间客户不需要进行干预。ER后续将会正式推出支持上传进项的边缘计算服务,支持到更复杂的边缘计算场景。同时现有的ER场景会支持更多程序语言,覆盖主流的开发语言和框架,加强同云中心的互动,包括数据库、存储等云产品。阿里云会持续去丰富边缘算力类型,对于不同的算力资源进行统一纳管和调度,不断丰富和提升边缘计算的能力。

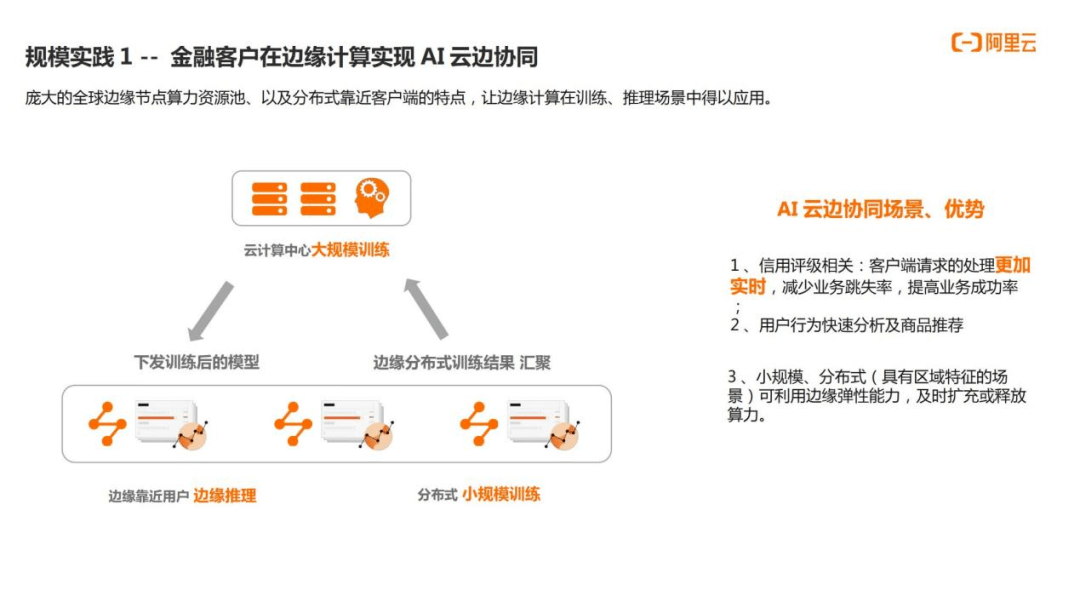

容蓓在演讲中分享两个边缘计算在边缘应用的案例。第一个案例金融客户在边缘计算实现 AI 云边协同。客户是一家比较知名的金融企业,企业的业务逻辑受到推理方面的一些限制,部分算力消耗较大的推理,没有办法在端上完成。如果将所有的推理都移到数据中心完成,除了增加带宽压力和算力的负载,端上的客户等待时间也会非常长,会造成超时、请求失败。在客户使用了ER上传进项的服务后,将部分推理逻辑部署在了边缘去完成,并且利用到了边缘区域的一些属性,来形成推理的区域特征,再将区域特征应用到业务判断里面去。在这套技术架构运行后,企业客户端的请求处理会更加及时、准确,业务的成功率也提升了5%以上。在使用时,客户是不需要关心用多少算力相关的技术动作,ER已经对算力弹性进行了扩容,在高峰期间会弹出更多容器进行服务。低峰的时候会释放掉,做到算力按量付费。

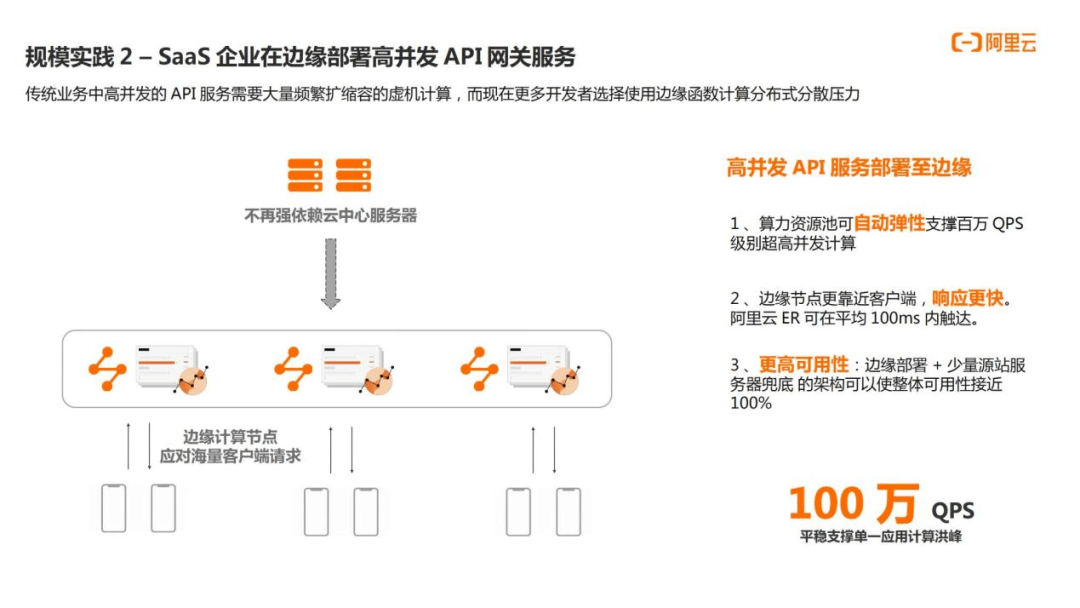

第二个案例是SaaS企业在边缘部署高并发 API 网关服务。阿里边缘会根据访问的热度,来自动扩容或缩容边缘的网关,客户端这时会离边缘更近,在服务过程中响应也会更及时,性能比在直接中心的网关更好。在边缘处理掉大部分的请求后,中心的带宽压力同步减少。客户也将边缘这套网关链路和中心网关链路做了储备,当任何一条链路出现问题的时候,可以自动系统切换到另外一条链路上面,整体提高了客户的可用性。

在访问的流量以及计算的应用下沉之后,考虑到安全问题,全站加速的边缘安全提供了完整的、原生的边缘和防护能力,在边缘层面也支持了基础防护、白名单等相关能力,并且支持3/4/7层的防护,支持智能的CC防护,在全球支持到Tbps级别的防护能力。在全站加速中大概有30%左右的客户,已经开通了边缘安全。随着流量和计算进一步下沉,边缘安全的比例一定会变得越来越高。在未来,阿里会持续打造适用于全球分布的安全能力,把安全前置到边缘,去降低在中心被攻击而带来的宕机风险,为运力和算力来做一个保驾护航。

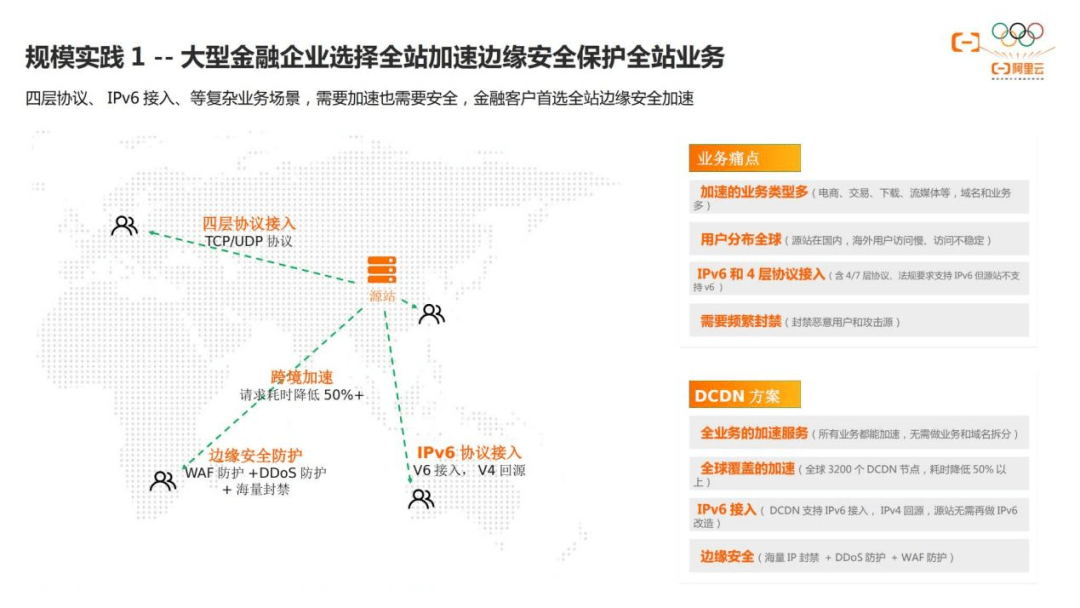

容蓓分享了两个边缘安全的案例进行讲解。第一个案例是大型金融企业选择全站加速边缘安全保护全站业务。金融企业的客户分布全球,客户的业务类型需要去支持多种协议,需要频繁在边缘去封禁恶意用户的访问,以及攻击源。全站加速提供了标准产品接入能力,全球节点覆盖,边缘提供海量的IP封禁,使客户业务在全球都可以平稳运行。

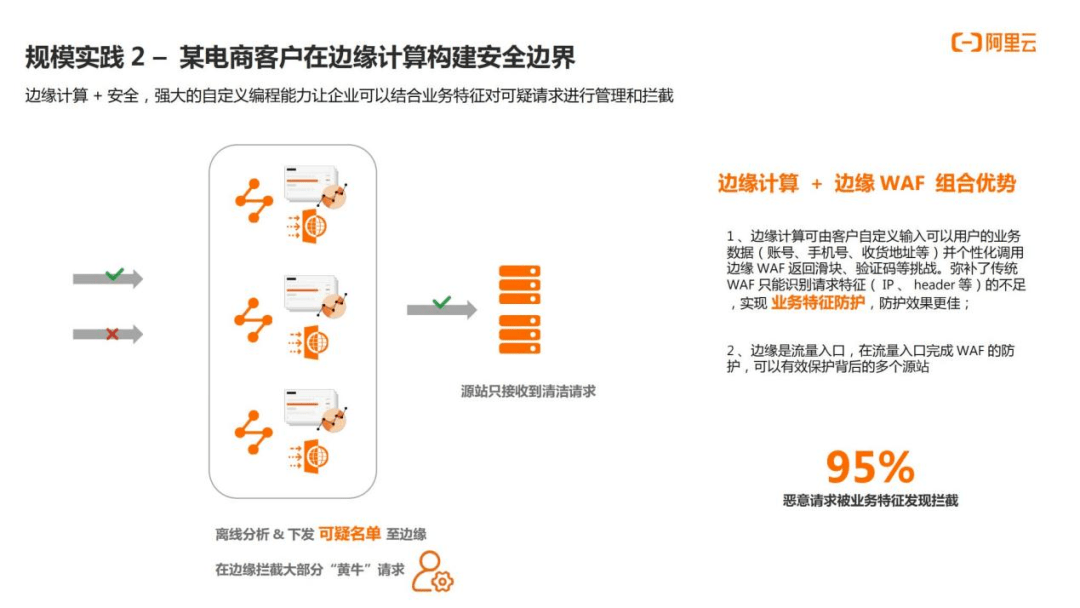

第二个案例是某电商客户在边缘计算加边缘安全构建了新的安全边界。该客户利用了边缘计算和边缘安全一起构建了一张防黄牛抢单的防护规则。电商公司在客户在下单之前,会根据用户的信息去判断端上的购买行为是不是黄牛,如果命中黄牛规则,会增加额外的验证,或者直接拒绝掉这一次服务。电商公司通过ER判断用户的业务数据如帐号、手机等信息,同时调用边缘WAF能力,让用户返回滑块、验证码等挑战。这一套机制弥补传统WAF只能通过请求特征来判断端上行为的一些不足。使用这套架构之后,电商企业业务特征的有效拦截率提升到了95%以上。

容蓓最后总结,全站加速可以为用户提供高性能的运力(全站加速)、算力(边缘计算)、防力(边缘安全)。阿里云后续也会持续服务更多客户,为客户提供稳定、易用、好用的产品。